Jak używać hashtagów na Instagramie w 2026 roku?

W 2026 widoczność na Instagramie nie zależy już od hashtagów w poście. Czy warto nadal z nich korzystać? Oto jak przygotować się na ostatnie zmiany.

Jeśli posiadasz stronę internetową, to z pewnością Twoim celem jest, by ta znalazła się w czołówce wyników wyszukiwania. I jest to wykonalne – pod warunkiem że Google Cię lubi. W tym artykule wyjaśnimy, czym jest crawl budget oraz jaki ma wpływ na zwiększenie widoczności w Google.

Wszystkie wysiłki osób zajmujących się SEO mają zazwyczaj ten sam cel: dobrą pozycję w wynikach wyszukiwania, najlepiej na pierwszej stronie.

Jest wiele rzeczy, które możesz zrobić, by ten cel osiągnąć: research słów kluczowych, tworzenie wysokiej jakości treści, stosowanie linków zewnętrznych i wewnętrznych, a także – na czym skupimy się w tym artykule – maksymalne wykorzystanie budżetu indeksowania oraz jego zwiększenie.

Koncepcja crawl budget to kwestia mocno techniczna; postaramy się jednak wyjaśnić w prosty sposób, czym dokładnie jest i jak można go zoptymalizować.

Zanim zaczniemy, musimy jeszcze krótko wyjaśnić trzy kluczowe pojęcia. Często terminy te są używane jako synonimy, ale tak naprawdę mają różne znaczenia. Chodzi o crawling, indeksowanie i pozycję strony.

Najpierw Googlebot skanuje (crawluje) stronę. Może to być nowa witryna z nową zawartością lub już istniejąca z zaktualizowaną treścią.

Strona jest następnie indeksowana, co oznacza, że trafia do bazy danych wyszukiwarki i może pojawiać się w SERP-ach.

Wreszcie dochodzimy do pozycji strony w wynikach wyszukiwania. Google decyduje, gdzie ją umieścić w odpowiedzi na zapytanie użytkownika.

Teraz możemy zaczynać.

Zagłębmy się od razu w tę definicję:

Za przeszukiwanie każdej strony w sieci odpowiedzialny jest pająk Google, zwany Googlebotem. Zajmuje się on raz w miesiącu deep crawlem, a prawie codziennie – fresh crawlem.

Googlebot odwiedza tak wiele adresów URL, jak to tylko możliwe, ponieważ Google jest głodny treści: jego celem jest bycie zawsze na bieżąco z nowymi treściami w sieci, aby dostarczać użytkownikom trafnych odpowiedzi na ich zapytania.

Czas, który Googlebot poświęca na indeksowanie i przeszukiwanie Twoich stron (i wszystkich innych) nie jest nieograniczony. Wręcz przeciwnie – nie wszystkie adresy URL udaje się indeksować regularnie. Dlatego optymalizacja budżetu poświęconego na to działanie jest kluczowa: im lepsza jakość strony, tym łatwiej ją odczytać i tym więcej czasu ma Googlebot, by się z nią zapoznać.

Googlebot nie będzie tracił czasu i zasobów na strony, których jakość uzna za niewystarczająco wysoką, lub jeśli uzna, że nie wnoszą one żadnej dodatkowej wartości do wyszukiwania użytkowników.

Pytania, które pojawią się w tym momencie, to:

Czy Google lubi moją stronę?

Jak dużo czasu Googlebot spędza na moich stronach?

Czy mogę zwiększyć crawl budget?

Odpowiedzi poznasz w dalszej części artykułu.

Przede wszystkim należy jednak wspomnieć, że budżet na indeksowanie nie jest dla każdego. Małe witryny z zaledwie kilkoma stronami nie będą musiały się o niego martwić. Jest to kwestia bardziej istotna dla większych witryn, takich jak redakcje i duże serwisy e-commerce, które muszą pokazywać użytkownikom zawsze aktualne wyniki.

Wyobraź sobie na przykład, że śledzisz mecz piłki nożnej: oczywiście będziesz oczekiwał, że rezultaty, które znajdziesz w SERP-ach będą pokazywały wynik w czasie rzeczywistym, a nie ten sprzed 15 minut.

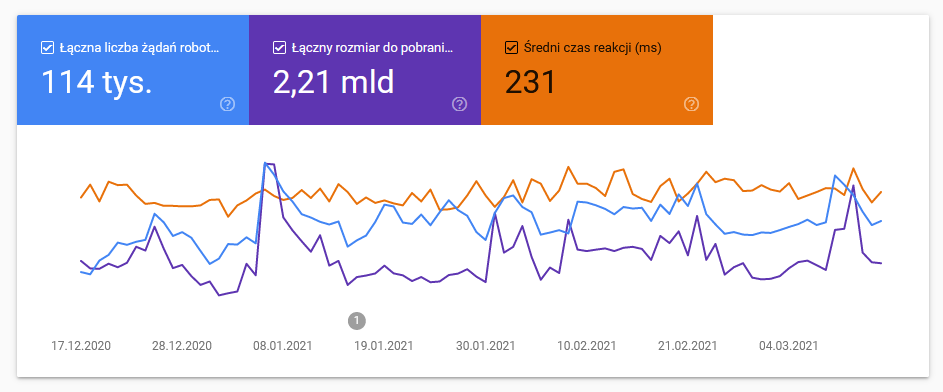

Przydatnym (i darmowym) narzędziem do śledzenia aktywności Googlebota na Twojej stronie jest Google Search Console. Dzięki niemu dowiesz się zarówno ile żądań na sekundę wyszukiwarka poświęca na Twojej stronie, a także ile czasu mija między jednym a drugim skanowaniem. W narzędziu sprawdzisz statystyki indeksowania z ostatnich 90 dni.

Zaloguj się do Google Search Console

Kliknij ⚙️ Ustawienia w lewym dolnym rogu.

Kliknij przycisk „Otwórz raport” w sekcji Statystyki indeksowania.

Wyświetlą się trzy wartości:

łączna liczba żądań robota indeksującego: niebieska linia wskazuje liczbę próśb o zindeksowanie Twojej witryny w wybranym przedziale czasowym,

łączny rozmiar do pobrania: fioletowa linia wskazuje rozmiar zasobów i plików pobranych podczas skanowania w wybranym okresie,

średni czas reakcji (ms): pomarańczowa linia wskazuje średni czas odpowiedzi strony na prośbę o zindeksowanie w celu pobrania jej zawartości.

W przypadku żądań skanowania łatwo stwierdzić, że im wyższa wartość tym lepiej. Dla pozostałych dwóch czynników jest odwrotnie. Optymalizacja wagi stron pozwala zarówno wyszukiwarce, jak i użytkownikom na łatwiejsze poruszanie się po niej.

Ponadto, szybsze pobieranie oznacza więcej stron, które mogą być indeksowane z dostępnego crawl budgetu.

Spokojnie – jeśli okazało się, że Twój budżet indeksowania nie jest bardzo wysoki, nie musisz rozpaczać.

Istnieją bowiem proste sztuczki, które sprawią, że pająk Google będzie częściej wracał na Twoją stronę.

Regularnie twórz nowe (wysokiej jakości!) treści

Regularnie aktualizuj treści (nowe i stare)

Róźnicuj rodzaje treści. Jest to więc nie tylko tekst, ale wszystko, co pojawia się na Twoich stronach – obrazy, filmy, pliki pdf...

Upewnij się, że organizacja Twojej sitemapy jest przejrzysta i czytelna dla Google, szczególnie jeśli strona jest bardzo duża. Odpowiednie linkowanie pozwala Googlebotowi nie tracić cennego czasu na ich przeszukiwanie. Nie zapomnij zsynchronizować sitemapy w Google Search Console.

Wykorzystaj linki wewnętrzne dla każdej z Twoich stron. W przeciwnym razie Googlebot, po przeczesaniu strony, na której ich brakuje, może trafić w „ślepy zaułek”.

Im więcej backlinków posiadasz, tym bardziej prawdopodobne jest, że Google będzie uważał Twoje strony za wartościowe. Backlinki są niezbędne do zwiększenia popularności Twojej witryny.

A popularność jest istotna. Jak Google pisze na swoim blogu, „Adresy URL, które są popularniejsze w internecie, są zwykle indeksowane częściej, aby zachować ich aktualność w naszym indeksie”.

Skutecznym sposobem na zwiększenie popularności witryny jest optymalizacja Off-Page SEO.

Teraz, gdy zastosowałeś się do powyższych wskazówek i udało Ci się przykuć uwagę Google, nadszedł czas, aby zwrócić uwagę na SEO oraz na to, jak możesz zoptymalizować swój budżet indeksowania. Przez optymalizację rozumiemy tutaj maksymalne wykorzystanie „niewielkiej” ilości czasu, jaką Googlebot poświęca na daną stronę.

Ryzykowanie, że Googlebot będzie tracił cenny czas np. na stronach, które nie mają żadnej wartości dodanej dla użytkowników lub mają zduplikowaną treść, jest posunięciem, które sprawi, że wszystkie inne Twoje wysiłki pójdą na marne. A tego chcesz oczywiście uniknąć.

Zawsze pamiętaj, że:

Choć może się to wydawać oczywiste, należy zaznaczyć, że tworzenie contentu o niskiej jakości przynosi efekt odwrotny do zamierzonego.

W rzeczywistości istnieje niebezpieczeństwo, że Googlebot będzie tracił czas na skanowanie takich stron, zamiast skupić się na tych o wysokiej jakości, popularnych i aktualnych. Google jest już bardzo dobry w swojej pracy, ale oczywiście możesz mu pomóc i ją ułatwić oraz przyspieszyć.

W tym celu możesz zoptymalizować dwie wartości crawl budgetu: zwiększyć go oraz zmniejszyć odstęp czasowy między kolejnymi przeszukiwaniami.

Szybkość działania jest kluczowa, ponieważ czas, jaki Googlebot spędza na stronie, nie jest ograniczony. Optymalizacja czasu pobierania strony oznacza danie mu dłuższego odcinka, który może poświęcić innym. Oto kilka wskazówek, które możesz zastosować:

zainwestuj w wysokiej jakości serwer,

zoptymalizuj kod strony, aby był bardziej czytelny,

skompresuj zdjęcia (ale bez utraty na jakości; Tinyjpg jest przykładem darmowego programu do redukcji rozmiaru pliku nawet o ponad 70 proc.).

Z pewnością kojarzysz grafikę obrazującą to, jak powinna wyglądać idealna struktura strony. Przejrzysta, prosta struktura witryny pozwala na lepsze wykorzystanie crawl budgetu (a wiemy już, że więcej czasu równa się więcej zeskanowanych lub zaindeksowanych stron).

Kieruj się popularną zasadą trzech kliknięć, która mówi, że maksymalna liczba kliknięć, jaką musi wykonać użytkownik, aby dotrzeć ze strony głównej do interesującej go podstrony, to właśnie trzy.

Wyeliminuj strony, do których nie prowadzą żadne linki wewnętrzne ani zewnętrzne.

Użyj kanonicznych adresów URL dla swojej witryny w sitemapie. Tag rel=canonical co prawda nie pomoże Ci w zaoszczędzeniu budżetu indeksowania, ale pozwoli Google szybciej zrozumieć, którą wersję strony rozważyć w pierwszej kolejności.

Linki wewnętrzne, które w zasadzie służą użytkownikowi do lepszego zagłębienia się w dany temat, powinny równocześnie wskazywać na strony, na które chcesz, aby Googlebot zwrócił większą uwagę.

Selekcjonując konkretne strony, masz większą szansę, że crawler Google je przeskanuje. Google przykłada większą wagę do stron, które zawierają dużo linków (zarówno wewnętrznych, jak i zewnętrznych).

Crawler nie trafi w „ślepy zaułek” po przeskanowaniu strony, na której ich brakuje.

Zepsute linki nie tylko obniżają Twoją pozycję w rankingu, ale także marnują cenny crawl budget. Unikaj więc statusów innych niż 200.

Linki no follow pozwalają zaoszczędzić budżet indeksowania, ponieważ są to odnośniki, które mówią Googlebotowi, aby nie tracił czasu na ich skanowanie. Mogą to być strony, które uważasz za jedne z najmniej ważnych w Twojej witrynie lub są już powiązane w ramach tematu, kategorii lub podobnych i nie powinny być skanowane wielokrotnie.

Robots.txt, prosty plik tekstowy, jest przydatny do blokowania nieinteresujących stron. Jest to przewodnik po zawartości każdej strony, który mówi Google, jak ją indeksować.

Robots.txt jest niezbędny, aby nie marnować czasu crawlera na te strony, które nie powinny być skanowane (np. adresy prywatne lub administratora), oraz aby wskazać te brane pod uwagę.

Podkreślmy jeszcze raz: odświeżanie treści prowadzi do zwiększenia ilości czasu, jaki Google spędza na stronie.

Każda recenzja oznacza nową treść, a w końcu dynamiczna strona pełna nowych treści to taka, którą Google docenia. Wiedząc, jak wykorzystać treści generowane przez użytkowników, nie tylko poprawisz swoją pozycję w wynikach wyszukiwania, ale także wzmocnisz swoją markę i wzbudzisz zaufanie przyszłych klientów.

Odrzucenie wszystkich już nieistotnych czy nieważnych stron lub takich, które z jakiegoś powodu nie pozyskują już ruchu, uchroni Cię przed marnowaniem budżetu indeksowania. Jeśli nie chcesz całkowicie stracić zawartości takich stron, możesz przenieść je na podobne lub nowe.

W tym względzie nie należy zapominać o backlinkach. Jeśli inne strony linkują do tej, którą zamierzasz usunąć, istnieją dwie opcje: przekierowanie 301, które informuje wyszukiwarkę, że strona jest dostępna z innego adresu URL, lub prośba o zmianę adresu URL backlinku bezpośrednio.

Odstęp czasowy pomiędzy kolejnymi crawlami koreluje ze wzrostem budżetu indeksowania.

Dzięki regularnej aktualizacji treści zauważysz wzrost liczby crawli Googlebota: za każdym razem bowiem, gdy ten odwiedza stronę i znajduje odświeżony content, Twój crawl budget ulega zwiększeniu.

Ale uwaga: publikuj stronę ponownie tylko po większej aktualizacji. Jeśli Google uzna, że treść po odświeżeniu jest taka sama lub bardzo podobna, ukarze Cię rzadszym skanowaniem.

Zarządzanie i zwiększanie budżetu indeksowania jest jednym z sekretów dobrej pozycji w wyszukiwarkach. Jeśli Twoje treści są dobre, a strony czytelne, częstsze indeksowanie prawie na pewno doprowadzi do wzrostu widoczności i popularności, czyli wartości, które Google docenia.

To, o czym zawsze należy pamiętać w kwestii crawl budgetu, jest fakt, że za wszelką cenę należy unikać niepotrzebnego marnowania energii i zasobów.

Jak jeszcze poprawić pozycję sklepu internetowego w Google? Dowiedz się tego z naszego bezpłatnego poradnika:

Ta publikacja jest tłumaczeniem artykułu w j. włoskim: Crawl budget: cosa è e come aumentarlo per migliorare il tuo ranking

18.03.2021W 2026 widoczność na Instagramie nie zależy już od hashtagów w poście. Czy warto nadal z nich korzystać? Oto jak przygotować się na ostatnie zmiany.

UOKiK sprawdza transparentność opinii w e-commerce, aby chronić konsumentów przed wprowadzającymi w błąd informacjami.